AIが、そのチャットで命令した「ルール」を忘れてしまう。

こんな経験はありませんか?

例えばChatGPTのような生成AIに下記のような命令を送ります。

あなたは次のようなルールを絶対守って私の依頼に応えてください。 ルール1:○○○ ルール2:××× ルール3:…

しかし、チャットが長くなるといつの間にかいくつかのルールを守らなくなってしまうのです。

それは何故でしょうか?

こちらの記事ではそういった生成AIのクセと対策を解説します。

AIが命令を「忘れてしまう」のは何故か?

まず、ChatGPTのような生成AIは基本的に「忘却」の動作を持っていません。

しかし、私たちが生成AIで長く会話を続けていると、まるで以前の話を忘れてしまったかのようにふるまうことがあります。

「機械なのになぜ?」と思いますよね。

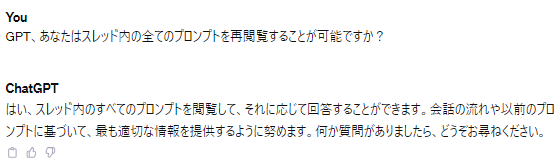

実際にChatGPTに質問をしてみるとこのような返答が返ってきます。

この会話では「GPTがスレッド内の情報を確認することは可能か?」との質問に対して「閲覧可能です。会話の流れに沿って適切に処理します」といった内容が書かれています。

どうにも我々との認識が違います。

実は、この時GPTは嘘の情報を返答しているわけではありません。

結論を言ってしまうと生成AIが命令を忘れてしまうのは、1度に処理するトークン数に限界がある為です。

トークン数とはここでは文字数のようなものだと考えてください。

1度の処理とは依頼文1つに対して1つの返答です。つまり依頼の往復の一動作にあたります。

例えばあるAIでは日本語で処理する文字数限界が一動作当たり2000文字だったと仮定しましょう。

あなたがAIに投げた質問は1200文字でした。しかしあなたの命令の中には800文字以上で返答するような命令が組み込まれていました。

そうすると、AIはあなたの800文字以上という返答要請を優先する場合、他の命令を「欠落させて」命令を実行しなければいけません。

その中にあなたの設定した大事なルールが組み込まれていたら、例えばその命令が全く実行されない可能性も出てきます。

これが、我々の感じるところの「AIが設定したルールを忘れてしまう」という内容に相当します。

ChatGPT3.5ではトークン処理の限界数値が16kとされていました。

これは日本語ではおおよそ8000文字に相当し、人間の一日の会話数にほぼ等しいとされています。

つまり、ChatGPTでも一日分程度の情報量までしか一度に処理することができないのです。

将来的にAIの忘れる機能はなくなる?

このAIの忘却に対しては既に対策が実装されているものも存在します。

これはAIに長期記憶を与える方法として設計されており以下の2つの要素から成り立ちます。

- メモリー Memory

- エンベディング Embedding

「メモリー」つまり記憶ですが、これは外部媒体に会話記録を保存しておくことを指します。つまりチャット本体の記憶ではなく、新たに記憶保存とそれを参照する箇所を与えます。

そして「エンベディング」はメモリー内の情報をカテゴライズすることを指しています。英語ではこれを方向性と表現しており日本語では「話題の方向性」といった考え方をするとわかりやすいかも知れません。

つまり、個々の外部記憶に「方向性」をカテゴライズしておき、与えられた命令と命令のカテゴライズに応じで「メモリー」から情報を引き出すようにするのです。

ただしこれには処理速度の問題が含まれていて、一概に外付けのメモリーがあるからと言って全ての動作が良くなるわけではありません。

データが多くなるほど参照箇所が増えますし、逆にAIに依頼を出す側であるわれわれ人間も依頼内容とルールを忘れることがあるかもしれません。

これらの問題の解決は、処理速度の向上によって改善が期待できますが、物理技術等も関わってきますので、コンピューター自体の性能向上が望まれるでしょう。

AIのクセと対策

AIはあらかじめステップ分けした項目も「同時に」行ってしまう可能性があります。例えば…

いずれまとめられてしまう例 あなたはSTEPに従い仕事を行ってください 【STEP1】 …… 【STEP2】 …… 【STEP3】 ……

このSTEPを無視して全ての動作を一緒にやってしまいます。

これはチャットが長くなると「一緒にやった方が効率がいいだろう」とそのチャット内で解釈する為です。

これも我々人間の命令(禁止事項)とAIの判断の優先度が変わっている事例と言えます。

ですので、チャット内での往復が長くなると予想される命令では、最初に命令した仕事の順番がAIによってまとめられて、期待する結果が返ってこないことが予測できます。

そうした動作が見られる場合は、命令する項目をよりシンプルにしましょう。

例えば一度の命令で【STEP】を提示せずに、手元でSTEPを管理し、一つひとつ命令を出す方がより臨んだ結果に近い物が出てきます。

2023年のAIではこうした「AIの良かれと思った動作」を防ぐことは難しいので、我々が命令をシンプルにしていくことで、出力内容を絞っていくことが成功につながります。

また、AIが命令を忘れてしまったり、反してしまってもそれは怒るようなことではありません。

我々はこれからAIを活用する上で、失敗からよりAIが使いやすい命令を組むという動作を学ぶ必要があるということです。