機械学習や深層学習(ディープラーニング)において、「ReLU(Rectified Linear Unit)」は、ニューラルネットワークの活性化関数としてよく使われています。

この関数は、特定の条件を満たすと非常に効果的に機能しますが、その一方で「ニューロンの死(死んだReLU問題)」という問題が発生することがあります。

この問題は、特にニューラルネットワークの学習過程でパフォーマンスが落ちたり、学習自体が進まなくなる原因となるため、理解しておくことが重要です。

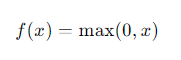

ReLU関数の基本

ReLUは、入力が0を超える場合にそのままの値を出力し、0以下の値をすべて0に置き換えるシンプルな関数です。

これにより、負の値を抑えつつ、計算コストを低く抑えた活性化関数として深層学習モデルで広く利用されています。

ReLU関数の数式

ここで、xが0以上の場合はその値がそのまま返され、xが0以下の場合は0が返されます。

死んだReLU問題とは?

死んだReLU問題とは、ニューラルネットワークの学習中にReLU関数が「死んで」しまう現象をいいます。

具体的には、ReLU関数が負の値を持つ入力に対しては常に0を返すため、一定のニューロンが学習中に全く活動しなくなる問題です。

この状態になると、そのニューロンは重みが更新されなくなり、モデル全体のパフォーマンスが低下します。

例: ニューラルネットワークが多くの層を持つ場合、ある層のニューロンが死んだReLU問題を起こすと、そのニューロンが下流の層に何も伝えられなくなります。

結果として、モデルが学習を進める能力が著しく制限されます。

死んだReLU問題の原因

- 大きな負の重み

学習中に勾配降下法を用いると、重みが非常に大きな負の値に引っ張られることがあります。

これが続くと、ReLU関数が常に0を出力するようになり、ニューロンが「死んで」しまいます。

- 学習率が高すぎる

高すぎる学習率は、重みの更新が過度に大きくなる原因となります。

これにより、ニューロンが死んでしまう可能性が高まります。

解決策

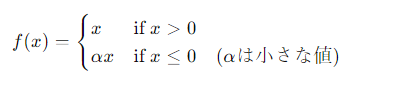

- Leaky ReLU

Leaky ReLUは、ReLUの改良版です。

負の値に対して完全に0ではなく、わずかに小さな勾配を持たせることで、ニューロンが完全に死ぬのを防ぎます。

- Leaky ReLUの数式

- 適切な学習率の選定

学習率を適切に設定することも死んだReLU問題の回避に役立ちます。

過度に高い学習率は避け、徐々に減衰させるなどの方法を検討すると良いでしょう。

- 初期化方法の工夫

重みの初期化も死んだReLU問題に影響を与えます。

適切な初期化を行うことで、ニューロンが死ぬ可能性を低減できます。

He初期化などの手法が推奨されます。

まとめ

ReLUは強力な活性化関数ですが、問題が発生することもあります。

死んだReLU問題は、ニューラルネットワークの学習過程でパフォーマンスを低下させる可能性のある問題です。

しかし、Leaky ReLUの使用や適切な学習率の設定、重みの初期化方法の工夫などを活用することで、この問題を回避できます。

これらの対策を実施することで、モデルのパフォーマンスを維持し、より効果的な学習を行うことができます。

死んだReLU問題を理解し、適切な対策を講じることで、より強力なニューラルネットワークを構築できるようになります。